热门主题

AI在金融行业应用的安全问题

2019-04-28 17:16:095549人阅读

随着金融工具变得越来越常见,利用这些工具的恶意方法也越来越多,未来攻击金融行业的行动也会越来越多。

AI增加了效率和风险

金融机构越来越依赖AI赋能的应用来将日常活动流水线化、评定客户风险、检测内部交易。但研究人员也证明了利用特定AI模型中的漏洞会影响系统的最终性能。攻击者可以利用金融AI应用的安全漏洞来进行破坏活动或者赢利。

数据投毒攻击或修改模型的训练数据会使系统生成不准确的结果或判定结果,影响系统的最终性能。攻击者通过逆向工程或入侵目标的机器学习管道可以获取模型的副本。下面是一些已知的安全问题:

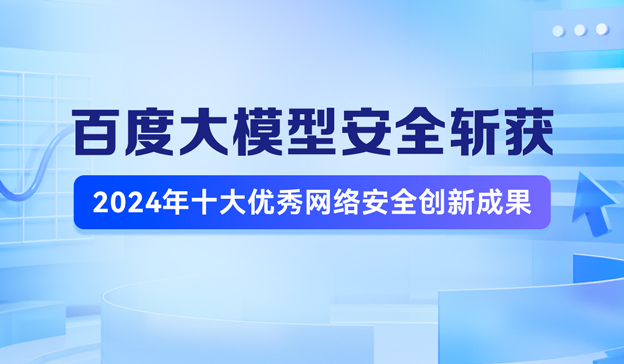

· 分类器安全问题。分类器主要是用来检测和识别的,比如网络中的恶意软件检测。研究人员发现分类器存在被绕过的风险,也就是说由于模式(mode)的内在问题,目标可能会被误分类,如图1所示。

图1: AI分类器将6识别为2的例子

图1: AI分类器将6识别为2的例子

· 数据投毒工具。数据投毒工具会影响AI推荐系统的结果。通过修改奖赏路径(reward pathways),攻击者可以创建一个模型来表示一个次优的输出。

· 情绪分析。自然语言处理应用可以分析文本和生成对要表达的观点的基本理解。研究表明如果用户输入破坏的文本训练样本到模型中会影响模型的整体性能,而且模型可能会误解文本的内容。

AI在金融行业的应用

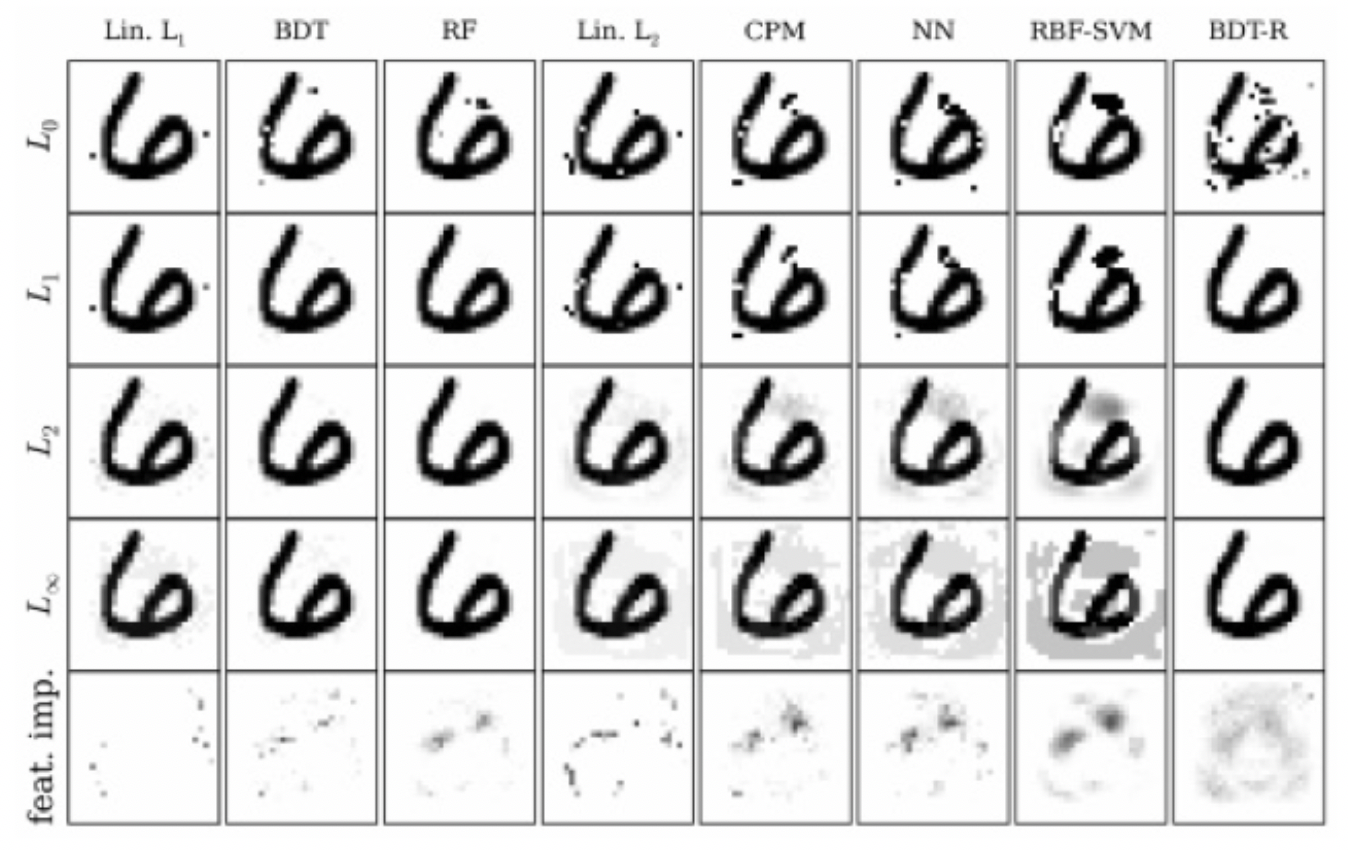

AI可以快速处理大量的数据,金融结构将AI技术和工具应用到风险分析、日常工作的流水线化中,如图2所示。

图2: 金融AI工具和潜在安全风险

图2: 金融AI工具和潜在安全风险

情感分析

自然语言处理这样的技术可以帮助分析师快速识别公众的讨论,分析会话的情绪以评定与企业相关的风险。

潜在风险

攻击者可以生成一些欺骗性的数据来生成公众对于交易的企业的错误分析。比如,攻击者可以伪造一些关于某公司的负面评论消息。FireEye就发现过攻击者利用伪造的消息来触发AI驱动的交易并引发金融恐慌。

图3: 叙利亚电子军控制美联社twitter账号后发的推文

图3: 叙利亚电子军控制美联社twitter账号后发的推文

证券管理

许多金融机构使用AI应用来选择股票进行投资,或使用基于AI的对冲基金来自动进行交易以获取最大利益。金融机构可以使用AI应用来帮助定制客户端的交易证券投资组合。AI应用可以分析客户的之前交易活动并提出与客户历史投资行为类似的投资建议。

潜在攻击

攻击者可以通过影响推荐系统的结果来使对冲基金进行不好的交易,给企业带来进行损失。

许多对冲基金使用的自动化交易工具都是没有无人值守的,而且交易会对市场产生直接的影响。因为无人值守,所以会对未来的自动化应用产生连锁影响。

投诉和欺诈检测

金融机构和监管机构也在使用基于AI技术的异常检测工具来确保交易方没有进行非法活动。这些工具可以检查交易活动、内部通信和其他员工的书来确保工作人员没有参与欺诈、窃取和内部交易等违法违规活动。

攻击者可以利用分类器中的漏洞来对基于AI的检测工具模型进行修改,使其将异常的非法活动分类(标记)为正常活动。对模型的修改会使用内部人员在进行违规活动时有恃无恐。

目前这类绕过欺诈检测系统的攻击还比较少,但是虽然AI金融工具的推广,利用这些工具的方法也会越来越多。

交易模拟

金融机构使用AI工具来通过之前的交易活动来模拟交易并检验其效果。定量基金经理和快速交易者可以利用这样的工具来进行投资规划,比如选择最优的交易时间。

潜在利用

通过利用AI模型的内在弱点,攻击者可以使企业产生安全的错觉。攻击者可以在企业训练AI模型时,将破坏的数据注入到用来训练模型的数据集中。然后,生成的模型和应用就会生成不准确的交易模拟和结果。这些模型都是在最新的金融数据上进行训练来改善模拟性能的,因此攻击者进行数据投毒攻击的机会非常多。

风险评估和建模

金融保险机构可以使用AI技术来对客户的数据进行检查。在市场分析师之前创建准确的保险策略需要风险评估来确定客户的潜在风险。金融服务机构也在使用AI应用来改善其风险模型。生成对抗网络(generative adversarial network)的发展可以通过测试企业的内部风险模型的能力来评估其性能或找出其漏洞以改善风险管理环节。

潜在攻击

如果一个国家正在与外国企业进行主要的市场活动,那么有政府背景或支持的攻击者就可以使用数据投毒攻击来使AI模型对该公司的价值或风险产生不准确的评价。目前已经出现过APT或其他有政府背景的攻击者发起了类似的攻击活动。

总结

企业在应用AI技术和应用时,既要考虑AI带来的潜在好处,也要考虑AI引入的风险和漏洞。AI模型并不是静态的,随着新信息、数据的加入,模型会随之变化以得出更加精确的结果。模型在训练的过程中会出现一些潜在的风险。企业应该对训练数据进行检查和周期性地审计。同时,AI应用应该加入人类的监管来确保错误的输出或者建议不会导致金融业务中断。

AI本身存在的问题可能会成为金融机构在人工智能技术应用过程中的障碍。比如,缺乏透明性,因为无法解释是如何得出这个结果的,因此无法判定结果的可信性。除此之外,各国对数据隐私的关注也使金融机构更加需要可解释AI。以GDPR为例,其中就明确要求AI应用对模型和决策进行解释。

本文作者ang010ela,原文链接https://www.fireeye.com/blog/threat-research/2019/03/breaking-the-bank-weakness-in-financial-ai-applications.html,转载需注明出处及本文链接