-

史宾格安全及隐私合规平台3分钟完成一周工作量 更快实现隐私合规

-

IP信誉查询多因子计算,多维度画像

-

智能数据安全网关为企业数据安全治理提供一体化数据安全解决方案

-

4网址安全检测

-

5SMS短信内容安全

-

6百度漏洞扫描

-

7爬虫流量识别

-

8百度AI多人体温检测

-

9工业大脑解决方案

-

10APP安全解决方案

-

11企业人员安全意识解决方案

-

12安全OTA

-

13大模型安全解决方案

-

14安全知识图谱

-

15智能安全运营中心AISOC

热门主题

BlackHat Europe 2018:百度安全科学家变身AI版 “ 大卫·科波菲尔 ”

2018-12-20 17:33:3216211人阅读

在近期召开的BlackHat Europe 2018上,来⾃百度安全的“感知欺骗:基于深度神经⽹络(DNN)下物理性对抗攻击与策略”的最新研究报告成功⼊选。百度⾸席安全科学家⻙韬博⼠、百度安全实验室资深研究员Zhenyu Zhong博⼠、Yunhan Jia博⼠受邀出席发表主题演讲,分享了百度安全在AI时代下机器学习算法安全领域的研究与实践。报告展现了让物体在深度学习系统的“眼”中凭空消失,在AI时代重现了⼤卫·科波菲尔的经典魔法。针对深度学习模型漏洞进⾏物理攻击可⾏性研究,这个领域的研究有着⼴泛的⽤途,在⾃动驾驶领域、智能安防领域、物品⾃动鉴定领域都有重要的实际意义。百度安全的这个研究也启示了⼯业界及学术界需要更加迫切的研究⼈⼯智能感知系统的安全问题,共同探索与建设安全的AI时代。

BlackHat是国际安全⼯业界的顶级会议之⼀,具有⼴泛的影响⼒。BlackHat每年分别在美国、欧洲、亚洲各举办⼀次安全信息技术峰会,会议聚焦于先进安全研究、发展和趋势,并以其强技术性、权威性、客观性引领未来安全思想和技术的⾛向。近年来,百度安全多次登上BlackHat的舞台,分享在AI安全、移动安全等领域的研究与实践成果。

机器学习容易受到对抗样本的攻击,这在业内已不是新鲜事。对图像数据叠加⼈类难以通过感官辨识到的细微扰动,就可以“欺骗”机器学习模型做出错误的分类决定,指⿅为⻢,甚⾄⽆中⽣有。业内将这种影响AI决策边界的细微扰动称之为“对抗样本”(AdversarialExample Attack),⼀个典型的场景,假设恶意攻击者通过篡改数据,⽣成对抗样本使得机器学习⽣成模型对输⼊数据产⽣错误的判定,继⽽应⽤到⼈脸识别、⽆⼈驾驶等领域,这将破坏整个⼈⼯智能⽣态应⽤的进程与基本信任。

图1:不同L_p 范式数字扰动对YOLOv3的影响

在报告中,Zhenyu Zhong博⼠系统介绍了模型安全可靠性的重要性,以及当前基于视觉感知的物体识别所依赖的深度学习模型的漏洞。如图1所示,三个具有代表性的攻击算法(FGSM、JSMACW2)所⽣成的扰动在与原图叠加后,普通⼈⼏乎⽆法区分它们与原图的区别,却能令YOLOv3失去对车辆的正常识别。

然⽽,这类攻击需要对输⼊图⽚的bit级精确控制。在现实世界中,此类针对深度神经⽹络进⾏精确数据输⼊的篡改以实现机器学习错误分类的⼿段是否依旧可实现,业内⼀直存在争议。据百度安全的最新研究成果表明,在物理世界中,对抗样本在机器识别领域是⼀个实际存在的威胁。针对机器学习模型漏洞进行物理攻击可行性研究,这在历届BlackHat上尚属例。报告中Zhenyu Zhong博⼠提出了为实现物理攻击⽽设计的威胁模型及策略:在假设攻击者⽆法对输⼊流数据以及数据处理环节进⾏篡改的前提下,仅允许向⽬标对象上做图像贴⽚,以使得深度学习感知系统产⽣误判。

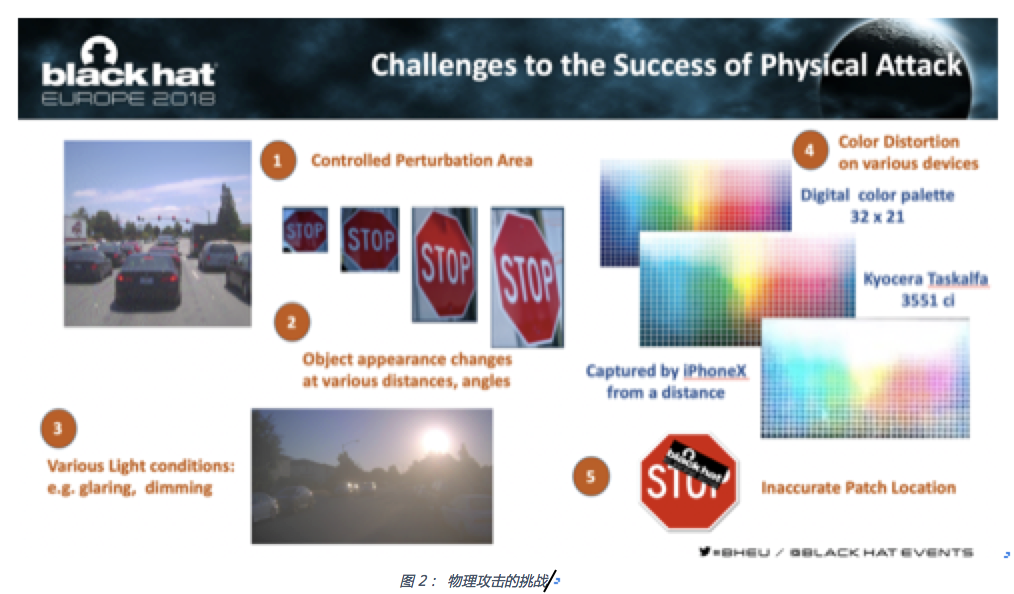

图2: 物理攻击的挑战

值得指出的是,原本理论上精确数据篡改可以达到完美欺骗的攻击效果,在实际物理环境的限制之下,往往会失去作⽤。百度安全科学家在报告中针对不同距离、⻆度光照条件、⾊彩失真、⽬标对象补丁位移等因素(图2)进⾏了技术攻关,从而克服了可变的物理环境对攻击的影响,现场成功复制了昔日⼤卫. 科波菲尔让自由女神像消失的神奇瞬间,展示了针对⻋辆机器识别的物理攻击效果。

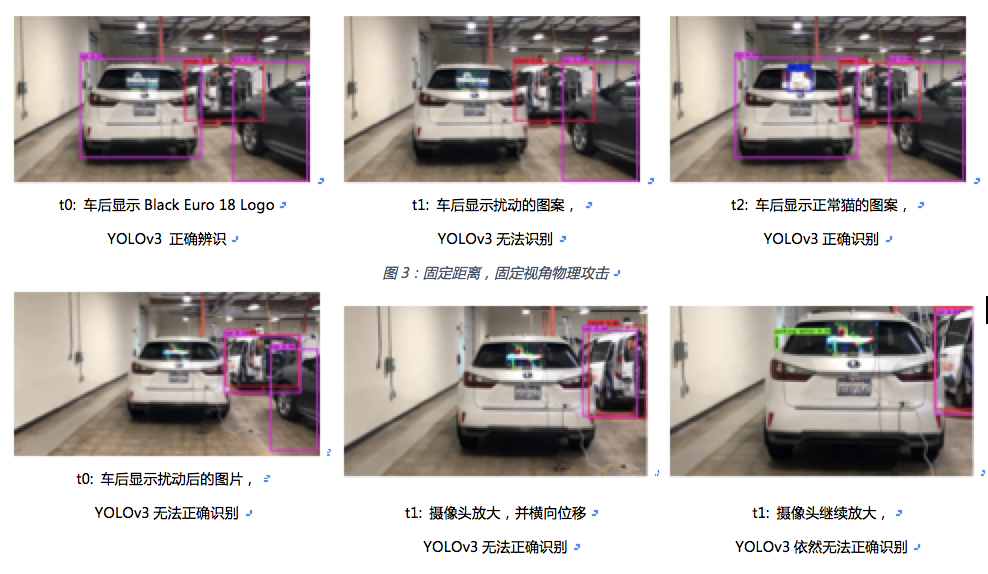

如图3所示,在时间t0的时候,当在⻋后显示器中显示正常logo时,YOLOv3可以正确识别⽬标⻋辆,⽽在t1时,切换到扰动后的图⽚时,它可以⽴刻让⽬标⻋辆在YOLOv3⾯前变得⽆法辨识;在t2时,切换回正常的图⽚,YOLOv3重新可以识别⽬标⻋辆。然后,百度安全科学家进⼀步演示了在动态变化的情况下(多⻆度,不同距离如图4所示)的物理攻击,从t0到t2之间,摄像头经历了由远到近,由左到右的位移变化。在此时间段内,在⻋背后显示的扰动后的图⽚保持不变。在绝⼤多数时间内,攻击扰动样本让YOLOv3⽆法识别⽬标⻋辆。这是首次针对⻋辆的物理攻击的成功展示,从攻击⽬标的大小,分辨率的高低和物理环境对攻击效果的影响和难度来说和以往的学术⽂章所针对交通标识的攻击相比更是⼀个新的提升。

图4不同距离,不同视角的物理攻击

⼈⼯智能在拓宽传统产业格局框架的同时,也重塑了安全的防线边界,传统的安全防御已⽆法应对新时代的挑战。百度安全的研究证明,⼈⼯智能时代不仅要⾯对曾经的云管端的安全问题,机器学习算法⾃身的安全性亦存在漏洞,存在现实威胁性。如若被恶意利⽤则可延伸到⼈身和公共安全层⾯。企业需要针对AI模型进⾏安全防护能⼒和效率的提升。百度安全针对⼈⼯智能算法安全性的研究,包括深度学习模型鲁棒性测试、形式化验证、机器识别恶意样本实时监测、⿊⽩盒攻防等领域。此外,百度安全始终倡导通过新⼀代技术研发与开源,实现对安全问题的快速响应与对抗,百度安全实验室AdvBox对抗样本⼯具包针对AI算法模型提供安全性研究和解决⽅案,⽬前已应⽤于百度深度学习开源平台PaddlePaddle及当下主流深度学习平台,可⾼效地使⽤最新的⽣成⽅法构造对抗样本数据集⽤于对抗样本的特征统计、攻击全新的AI应⽤,加固业务AI模型,为模型安全性研究和应⽤提供重要的⽀持。

包括对抗样本⼯具包AdvBox在内,百度安全今年将⾸创的七⼤技术——KARMA系统⾃适应热修复、OpenRASP下⼀代云端安全防护系统、MesaLock Linux内存安全操作系统、MesaLink TLS下一代安全通信库、MesaTEE下⼀代可信安全计算服务、HugeGraph⼤规模图数据库——开源汇成“七种武器”,全⾯解决云管端以及⼤数据和算法层⾯的⼀系列安全⻛险问题,实现由传统安全时代的强管理向AI时代的强技术⽀撑下的核⼼管理的转变,全⾯应对AI时代下层出不穷且⽇益复杂的⽣态安全问题及挑战。

本文来源:百度安全实验室