热门主题

百度安全亮相CIS 2019大会指纹攻击领衔盘点AI模型安全前沿进展

2019-11-29 11:01:438165人阅读

在人工智能的浪潮席卷全球之时,安全从来都是一个不容忽视的议题。而在这之中,扮演着重要基石角色的AI模型安全尤为受到关注。

11月27日至28日,CIS 2019网络安全创新大会在上海举行。作为本届大会人工智能安全前沿论坛的主办方,来自百度安全的技术专家在会上分享了关于云端AI服务攻击与防护方面的最新进展与研究成果。

众所周知,随着云计算与AI的融合发展,基于云服务的AI技术方案正在被越来越广泛地应用于图像分类、图像审核、人脸识别、语音识别、语音合成、文本情感分析及文本内容过滤等场景。相较于传统的本地化方案,云端AI服务不仅可以有效降低硬件部署成本和开发难度,也便于GPU集群资源的利用及模型优化。同时,由于绝大部分主流科技企业将其作为一种云服务打包方案,仅提供最终调用结果而不公开其预处理环节和模型细节,故这类服务抑或说“云端黑盒模型”模式通常也被视作是安全的,可以有效抵御对抗样本的攻击。

但是,与这一普遍认知相反,百度安全的最新研究却发现:云端黑盒模型制造的仅仅是虚假的安全感,在模型架构、参数及输入规则不可知的情况下,攻击者依然有机会实施对深度学习模型的欺骗。

百度安全技术专家在CIS 2019大会发表演讲

“指纹攻击”是百度安全在今年于新加坡召开的BlackHat Asia 2019中首次对外公开的研究成果,并揭示了当前深度学习模型训练常用的迁移学习方法所存在的安全缺陷。

由于特征提取层的架构和参数可被重复利用,特征值和架构也能够保持不变,基于迁移学习的训练方法在业内有着颇被推崇的高效性。然而,这也导致其模型所使用的特征提取层可以通过一定的攻击手段进行推算。在百度安全的实验中,研究人员根据极少的请求结果实现了对模型结构的推测,并按照“白盒”方式精确构造针对性对抗样本,从而完成对云端模型的定向和非定向攻击。

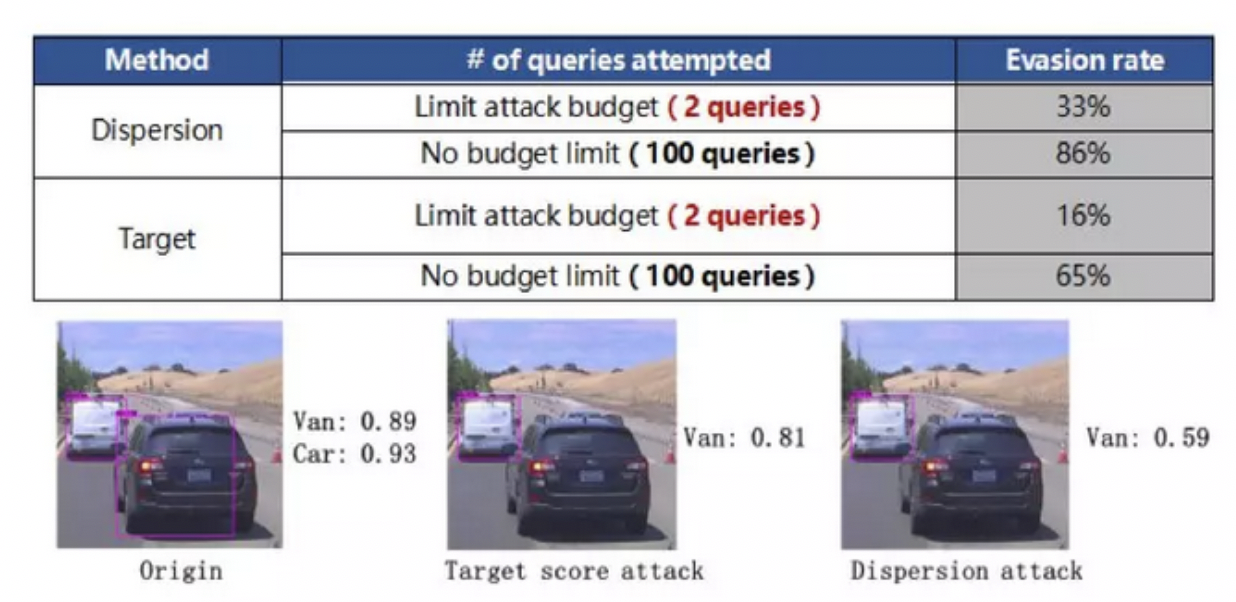

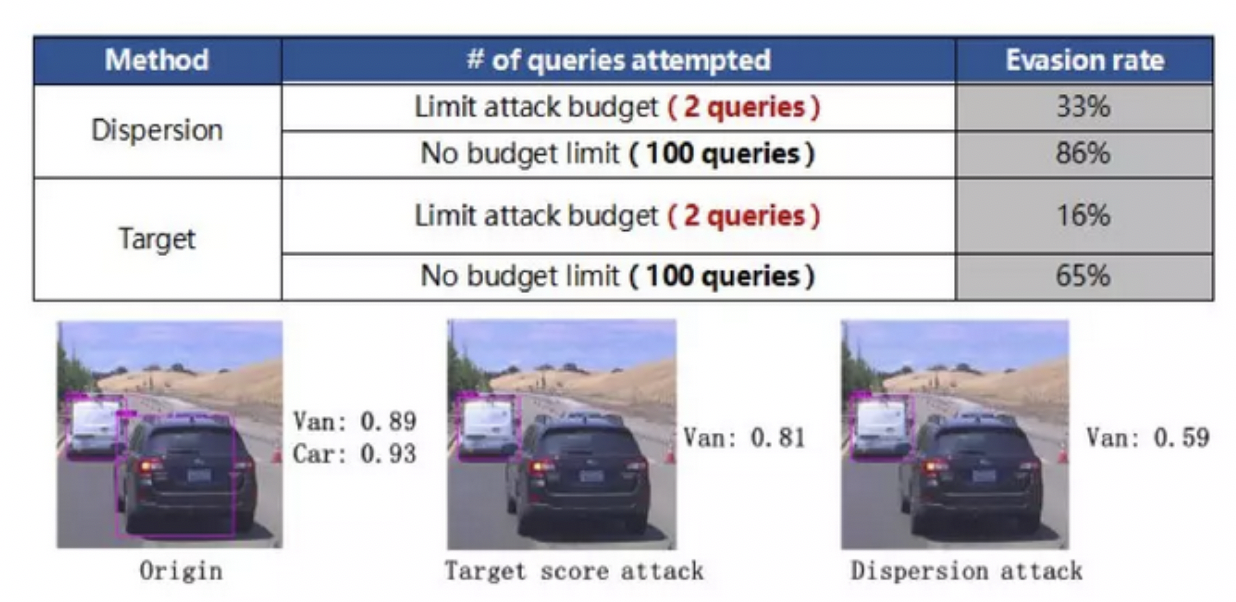

在上述实验中,在攻击者条件充足的情况下,攻击的绕过率分别高达86%(非定向)和65%(定向),而在条件不充足(比如仅支持2次请求)的情况下,攻击的绕过率也可以达到33%(非定向)和16%(定向)。换句话说,当AI模型面对相对高频的指纹攻击时,其安全性已不足以应对风险。

关于指纹攻击的研究细节,点击下面的链接查看:

百度安全亮相Black Hat Asia 2019:当云端深度学习模型失去“黑盒保护”

深度学习模型有限请求绕过率

如果说指纹攻击揭露了迁移学习训练方法中的安全隐患,那么在刚刚结束的于阿布扎比举行的HITB+CyberWeek大会上,百度安全所展示的基于快速特征图的PGD攻击算法(FFL-PGD),便提供了在“作案工具”方面的预警——其验证了在模型架构、参数及输入规则不可知的情况下,攻击者依然可通过有限的查询次数,利用同一张对抗图像,令大部分云端图像分类模型做出错误判断。

与传统PGD攻击仅使用分类损失致使模型做出错误的分类判断不同,基于快速特征图的PGD攻击算法引入了模型多卷积层特征损失并着力降低对抗样本图片与原图之间的差异。在百度安全的研究人员针对某云端图像分类服务发起的攻击测试中,“盲打”条件下仅通过2次查询(首次为正常查询,利用云端API的反馈结果构建小量数据集既而借此训练替代模型;第二次查询为利用替代模型生成的对抗样本对云端API发起攻击),即令一只猫“秒变”一棵树,完成全部攻击过程。

关于基于快速特征图的PGD攻击算法的研究细节,点击下面的链接查看:

聚焦HITB + CyberWeek 2019 ¦ 云端黑盒模型安全伪命题?攻击只需2步!

依托FFL-PGD仅通过2次请求便成功“欺骗”云端黑盒图像搜索引擎

这是百度安全今年在国内专业安全会议中对自身在AI模型安全领域研究进展的一次最新盘点。当然,百度安全在这一领域的研究也不仅限于数字世界层面,亦涵盖物理世界的对抗样本攻击。

例如在去年年底举行的BlackHat Europe 2018上,基于车辆场景,百度安全的技术专家便分享了BlackHat历史上首例针对深度学习模型漏洞进行物理攻击的可行性研究成果。并展示了在不同距离、角度、光照条件、色彩失真、目标对象补丁位移等可变物理环境因素下,仅通过向目标对象做图像贴片即可造成深度学习感知系统误判、实现物理攻击的效果演示。

AI模型是人工智能的重要核心,随着万物互联的不断延展与深入,其在数字世界与物理世界的联动作用下共同构筑起AI模型安全性的基石。

从针对Deepfakes“换脸术”开源业内首个AI换脸检测工具,到推出“七种武器”之一、聚焦于模型安全性的AdvBox对抗样本工具箱,秉承“有AI,更安全”的使命,百度安全在AI安全模型攻防领域展开了长期而广泛的前沿探索。而与此同时,我们也深刻意识到,在一系列研究进展背后,针对AI模型的新型攻击手段也在不断演化。集结中外安全圈最广大的力量,共同守护AI模型防线,打造AI时代安全生态,正在成为共识并化作行动。

在这之中,安全蓝军的身影自然不能缺席。与CIS 2019大会同期,百度安全应急响应中心(BSRC)也联合漏洞盒子开启了漏洞马拉松的进程。在此期间,除丰富的日常奖励外,BSRC也推出多项线上活动,包括新老白帽入驻、优质漏洞悬赏计划、团队额外奖励在内的多种福利回馈广大白帽。而此次漏洞马拉松的优胜者也将有机会获得额外奖励——与众多精英白帽一同“出海”,共赴BSRC年度盛典。

我们欢迎更多正义的白帽子、安全团队加入BSRC,共同建设简单可信赖的互联网健康生态。